Georgian Bay – Letni krajobraz

Zmiana sposobu robienia zdjęć

W ostatnich latach wielu producentów wyprodukowało kamery, które są w stanie wytwarzać obrazy o wyższej rozdzielczości dzięki technologii zwanej Sensor-Shift Technology. Technologia ta stała się możliwa wraz z pojawieniem się stabilizacji obrazu w ciele (IBIS). Projektanci aparatów wykorzystali IBIS jako sposób na uzyskanie niesamowitego wzrostu rozdzielczości obrazu lub poprawienia informacji o kolorach wykonywanych zdjęć.

Istnieje wiele nazw tej technologii, w tym tryb wysokiej rozdzielczości, system rozdzielczości z przesunięciem pikseli, tryb zdjęć wielokrotnych z przesunięciem piksela lub bardziej ogólne nazwy przesunięcia piksela/przesunięcia czujnika, ale w końcu wszystkie koncepcje tej technologii ten sam. Wiele obrazów tego samego widoku jest wykonywanych w taki sposób, że obrazy są układane w stos i mieszane w celu utworzenia jednego, zwykle dużego obrazu o wysokiej rozdzielczości.

Istnieją mocne i słabe strony tej nowej technologii, a zrozumienie, jak to działa, może pomóc w robieniu lepszych zdjęć samodzielnie, jeśli masz aparat, który jest w stanie to zrobić.

UWAGA: Ponieważ witryny używają obrazów o niższej rozdzielczości, obrazy użyte w tym artykule zostały zmniejszone i zmodyfikowane, aby symulować różnice między obrazami o wysokiej rozdzielczości a standardowym wyjściem z kamer. Patrząc na obrazy w całości, obrazy wyglądają podobnie, ale kiedy zbliżasz się do szczegółów na obrazach, zaczynasz dostrzegać różnice.

Gerbera stokrotki w pomieszczeniach, normalna rozdzielczość (20 MP) Olympus OMD EM 1 Mark II

Gerbera stokrotki w pomieszczeniach, wysoka rozdzielczość (50 MP) Olympus OMD EM 1 Mark II

Wiele podejść do obrazów z przesunięciem czujnika

Przechwytywanie obrazu z przesunięciem czujnika zostało przekształcone z drogich kamer specjalistycznych, aby stać się coraz bardziej dostępną funkcją w nowszych kamerach zorientowanych na rozdzielczość. Dzisiaj, oprócz potwornego H6D-400c Hasselblada (obrazy 400 megapikseli), istnieją oferty od Olympus, Pentax, Sony i Panasonic.

Wersje te generalnie wykorzystują to samo podejście koncepcyjne, ale w znacznie bardziej przystępnych cenach.

Ruch czujnika zmiany biegów

Kto używa Sensor-Shift?

Niezależnie od producenta, podstawowe działanie przechwytywania obrazu z przesunięciem matrycy pozostaje takie samo. Zrób wiele zdjęć, ale przesuwaj delikatnie czujnik aparatu dla każdego obrazu, aby przechwycić więcej danych obrazu, a następnie złożyć obraz.

Przesuwając czujnik, poprawiają się dane dotyczące kolorów obrazu, co pozwala na uzyskanie większej ilości szczegółów przez przezwyciężenie nieodłącznych problemów związanych z fotolokalizacją o określonym kolorze. Ignorując Hasselblada, systemy wykorzystujące tę technologię obejmują aparaty takie jak Olympus OM-D E-M1 Mark II (Micro Four Thirds), Pentax K-1 Mark II DSLR, Sony a7R III i Panasonic Lumix DC-G9 (Micro Cztery Trzecie), chociaż istnieją inne od tych samych producentów.

Trzy z tych linii to aparaty bezlusterkowe, a Pentax to lustrzanka cyfrowa z czujnikiem kadrowania. Warto zauważyć, że aparaty Panasonic/Olympus przyjmują jedno podejście, a Pentax/Sony inne podejście do tych samych koncepcji.

Systemy Olympus/Panasonic stosują podejście, które umożliwia tworzenie bardzo dużych obrazów o wysokiej rozdzielczości, podczas gdy systemy Pentax i Sony wykorzystują przesunięcie czujnika w celu poprawy informacji o kolorze w obrazach o tym samym rozmiarze. Zarówno systemy Pentax, jak i Sony pozwalają również na oddzielenie pojedynczych obrazów przesuniętych przez czujnik, podczas gdy Olympus i Panasonic łączą ułożone obrazy w jedno zdjęcie.

Olympus OMD EM5 Mark II posiada technologię przesunięcia czujnika.

Jak działa technologia czujników?

Aby zrozumieć, jak działa technologia przesuwania czujnika, musisz również zrozumieć, jak czujnik ogólnie działa na bardzo małą skalę. W dawnych dobrych czasach fotografii filmowej aparaty fotograficzne wykorzystywały błonę światłoczułą do rejestrowania obrazów. Aparaty cyfrowe wykorzystują zupełnie inne podejście do nagrywania światła.

Aparaty cyfrowe wykorzystują światłoczułe fotodiody do rejestrowania światła padającego na czujnik. W większości aparatów cyfrowych każda fotodioda ma określony filtr koloru (czerwony, zielony lub niebieski), tworząc fotomiejsce. Te fotomiejsca są rozmieszczone tak, aby umożliwić mieszanie się światła, aby zobaczyć kolor z obrazu wpadającego na czujnik.

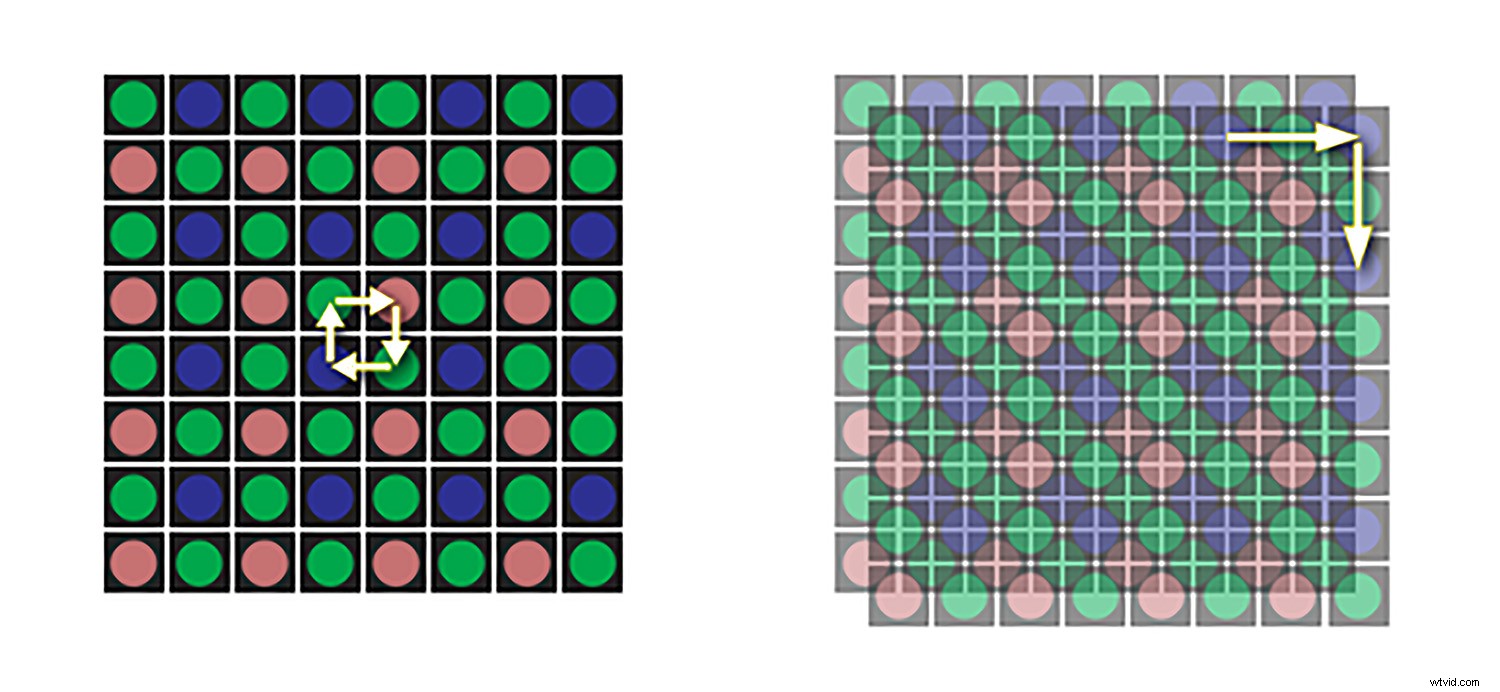

Czerwone, zielone i niebieskie fotomiejsca na czujniku są na ogół ułożone według określonego wzoru, znanego jako macierz Bayera (czyli macierz Bayera, filtr). Istnieją również inne konfiguracje, takie jak czujnik Fuji X-Trans (używany w kilku modelach ich aparatów) lub Sigma, która wykorzystuje czujnik Foveon.

W układzie Bayera jest dwa razy więcej zielonych fotomiejsc niż czerwonych lub niebieskich, ponieważ ludzkie widzenie jest najbardziej nastawione na rozwiązywanie szczegółów w kolorze zielonym. Ten układ ogólnie działa dobrze, ale jeśli się nad tym zastanowisz, na obrazie powstaje kolorowy piksel poprzez zmieszanie tych fotostron.

Czujnik nie wie, ile czerwieni znajduje się na zielonym lub niebieskim miejscu czujnika, dlatego wymagana jest interpolacja. Może to powodować pewne artefakty na zdjęciach, jeśli przyjrzysz się bardzo uważnie, i zwykle oznacza to, że obrazy RAW mają odrobinę nieostrość. Wszystkie obrazy RAW wymagają pewnego wyostrzenia w przetwarzaniu końcowym (zielony, czerwony i niebieski dla piksela są ze sobą mieszane).

Wzór Bayer fotostron

Czujniki statyczne

W zwykłej kamerze bez systemu IBIS każda fotokomórka rejestruje światło tylko jednego koloru w tym jednym miejscu, więc dane, które rejestruje, są technicznie niekompletne. Jest jak wiadro, które zbiera tylko światło o określonym kolorze. Klaster jasnych kubełków we wzorze Bayera służy do tworzenia pojedynczego piksela na obrazie cyfrowym, ale w tym pikselu znajdują się dwa zielone kubełki, jeden niebieski i jeden czerwony.

Aby scalić obraz i umieścić jeden kolor w tym jednym pikselu, sygnały z klastra fotodiod są rozdzielone razem. Zebrane dane są interpolowane za pomocą algorytmu demozaikowania w aparacie (jpeg) lub na komputerze (z obrazu RAW), proces, który przypisuje wartości dla wszystkich trzech kolorów dla każdego fotoobiektu na podstawie zbiorczych wartości zarejestrowanych przez sąsiednie foto-obiekty .

Powstałe kolory są następnie wyprowadzane jako siatka pikseli i tworzona jest fotografia cyfrowa. Częściowo dlatego obrazy RAW mają nieco bardziej miękką ostrość i muszą zostać wyostrzone w procesie postprodukcji.

Ruchome czujniki

IBIS oznacza, że czujniki poruszają się teraz nieznacznie, aby dostosować się do subtelnych ruchów kamery, aby obraz był stabilny. Niektórzy producenci twierdzą, że ich systemy są w stanie ustabilizować kombinację czujnika i/lub obiektywu na ekwiwalent 6,5 stopni.

Przesuwanie czujnika umożliwia wszystkim kolorowym fotokomórkom rejestrowanie danych dla każdej lokalizacji na czujniku.

Stabilizację tę uzyskuje się poprzez mikroregulacje położenia czujnika. W przypadku obrazów z przesunięciem czujnika te same mikroregulacje są używane do naświetlania każdej fotobudki na światło pochodzące z jednego nagrania obrazu. Zasadniczo czujnik jest przesuwany, aby nie dostosowywać się do zewnętrznych zakłóceń, ale aby każda część obrazu zawierała informacje w pełnym kolorze.

Strony fotograficzne zamiast pikseli

Być może zauważyłeś termin „fotosites” zamiast pikseli. Kamery są często oceniane na podstawie ich megapikseli jako miary ich zdolności rozdzielczej, ale jest to mylące, ponieważ w rzeczywistości kamery nie mają pikseli tylko fotosite.

Piksele znajdują się na obrazie wytwarzanym podczas przetwarzania danych z czujnika. Nawet termin „przesunięcie piksela”, który jest czasami używany, jest mylący. Piksele się nie poruszają, to czujniki, na których znajdują się fotoobiekty, poruszają się.

W przypadku przechwytywania pojedynczego obrazu, każda fotokomórka rejestruje dane dla światła czerwonego, zielonego lub niebieskiego. Dane te są interpolowane przez komputer, dzięki czemu każdy piksel w wynikowym zdjęciu cyfrowym ma wartość dla wszystkich trzech kolorów.

Czujniki zmiany biegów

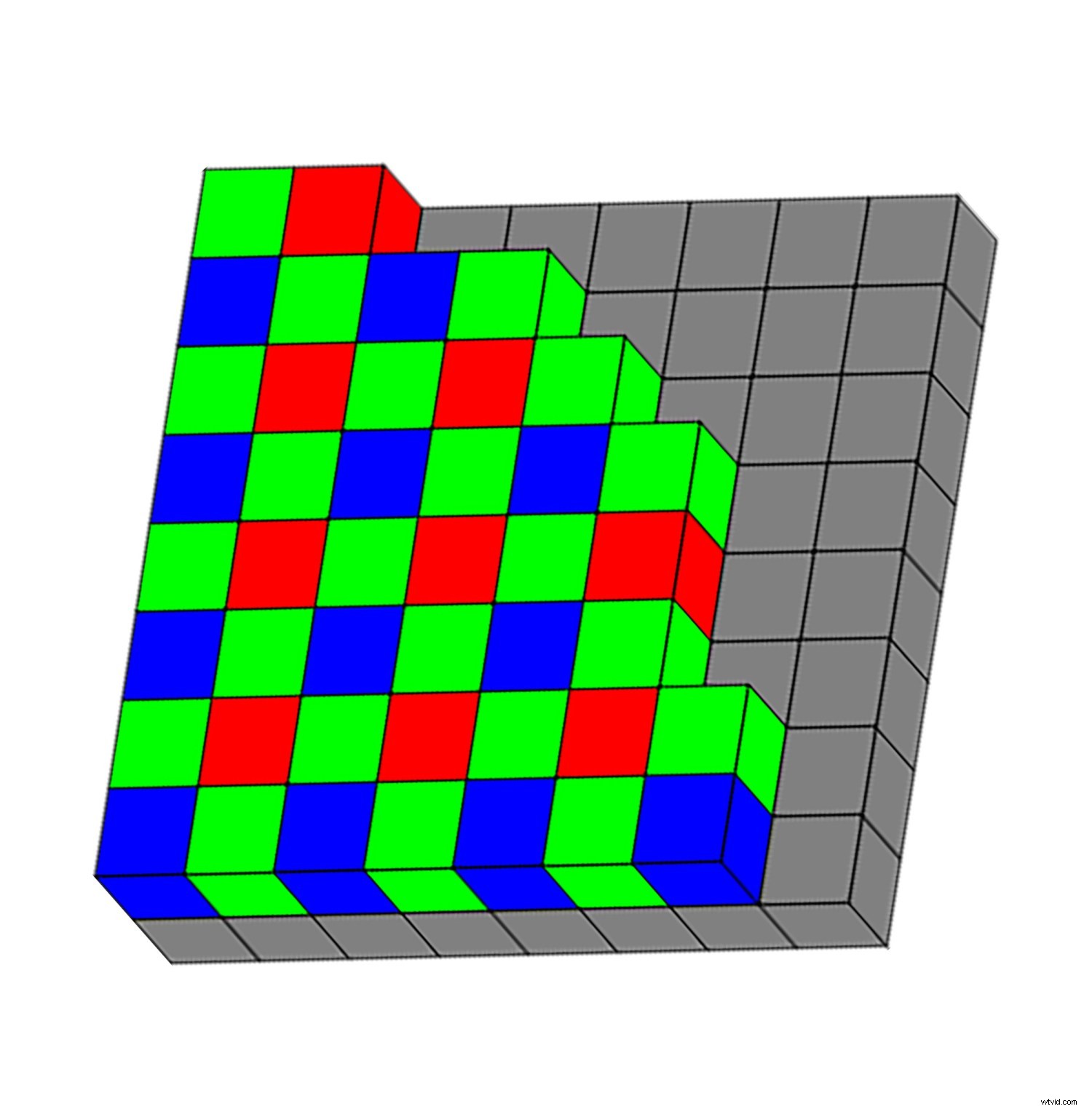

Kamery z przesunięciem czujnika próbują zmniejszyć zależność od interpolacji, przechwytując dane koloru czerwonego, zielonego i niebieskiego dla każdego wynikowego piksela, fizycznie przesuwając czujnik aparatu. Rozważ kwadrat o wymiarach 2×2 pikseli pobrany z fotografii cyfrowej.

Konwencjonalne przechwytywanie cyfrowe przy użyciu macierzy firmy Bayer zarejestruje dane z czterech fotolokalizacji:dwóch zielonych, jednego niebieskiego i jednego czerwonego. Technicznie oznacza to, że brakuje danych dla niebieskiego i czerwonego światła w zielonych fotosytach, zielonych danych i czerwieni w niebieskich fotosytach oraz niebieskiego i zielonego w czerwonych fotosytach. Aby rozwiązać ten problem, brakujące wartości kolorów dla każdej witryny zostaną określone podczas procesu interpolacji.

Ale co, jeśli nie musiałbyś zgadywać? Co by było, gdybyś mógł mieć rzeczywisty kolor (czerwony, niebieski i zielony) dla każdej fotostrony? To jest koncepcja technologii przesunięcia czujnika.

Obraz o normalnej rozdzielczości.

Nurkowanie głębiej

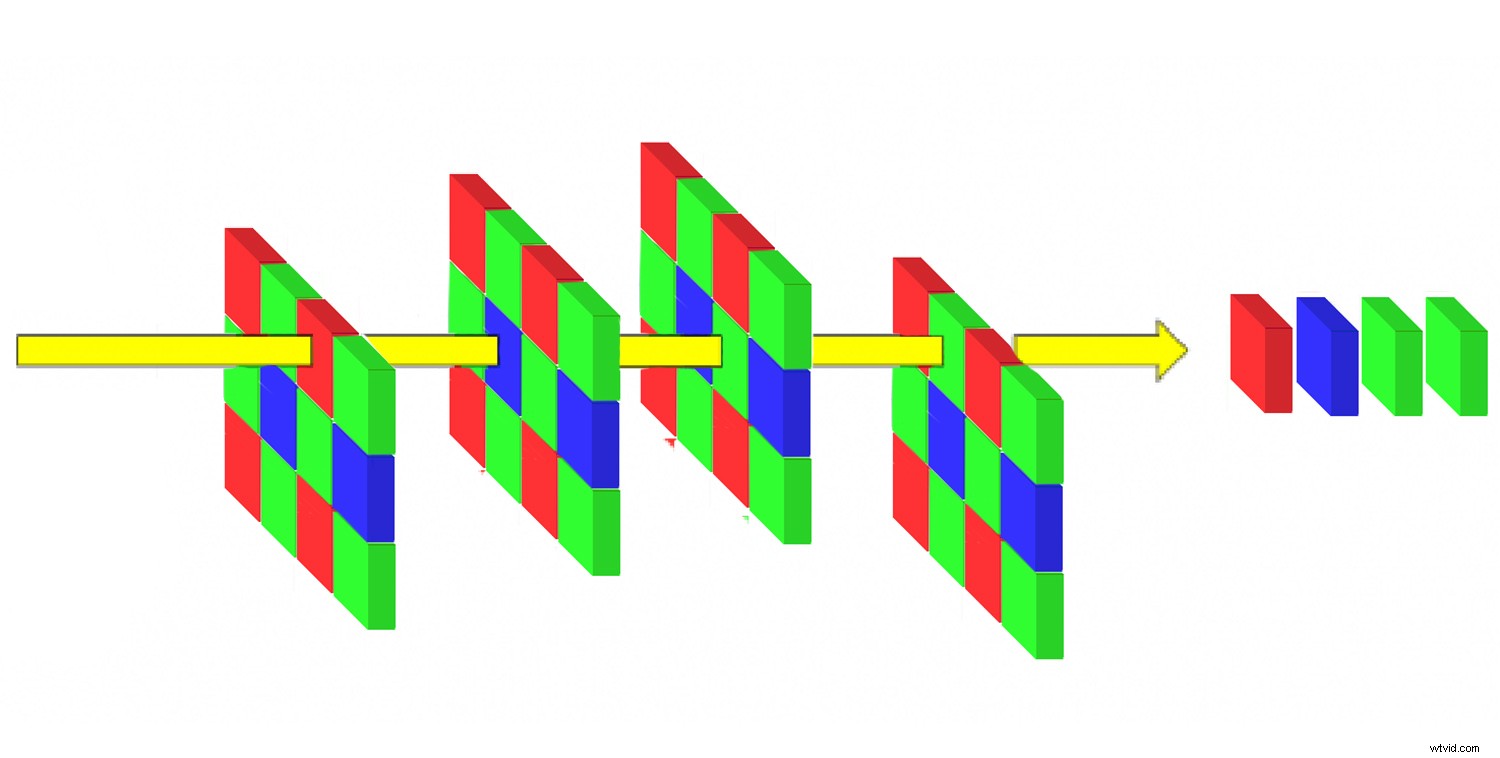

Rozważ kwadrat o wymiarach 2×2 piksele na fotografii cyfrowej, która została stworzona przy użyciu technologii pixel-shift. Pierwsze zdjęcie zaczyna się normalnie od danych zarejestrowanych z czterech fotolokalizacji. Jednak teraz kamera przesuwa czujnik, aby poruszać fotolokalizacją i ponownie wykonuje to samo zdjęcie, ale z inną fotobudką.

Powtórz ten proces, aby wszystkie fotomiejsca miały całe światło dla każdego dokładnego miejsca na czujniku. Podczas tego procesu dla każdego piksela pozyskiwane są dane świetlne z czterech fotolokalizacji (dwie zielone, jedna czerwona, jedna niebieska), co daje lepsze wartości kolorów dla każdej lokalizacji i mniejszą potrzebę interpolacji (wyuczone zgadywanie).

Obraz o wysokiej rozdzielczości przy tej samej czułości ISO, przysłonie i czasie otwarcia migawki.

Podejście Sony i Pentax

W ten sposób działają Sony Pixel Shift Multi Shooting Mode oraz Pentax Pixel Shifting Resolution System. Należy pamiętać, że korzystanie z tych trybów nie zwiększa całkowitej liczby pikseli w końcowym obrazie. Wymiary plików wynikowych pozostają takie same, ale dokładność kolorów i szczegółowość są lepsze.

Sony i Pentax robią cztery zdjęcia, przenosząc jeden pełny fotosite na zdjęcie, aby utworzyć pojedynczy obraz. To naprawdę jest po prostu poprawa informacji o kolorze na obrazie.

Podejście Olympus i Panasonic

Tryb wysokiej rozdzielczości aparatów Panasonic i Olympus, które wykorzystują matryce Mikro Cztery Trzecie, wykorzystuje nieco bardziej zniuansowane podejście, łącząc osiem ekspozycji wykonanych w odstępie ½ piksela od siebie. W przeciwieństwie do Sony i Pentax, znacznie zwiększa to liczbę pikseli w wynikowym obrazie.

Z matrycy o rozdzielczości 20 megapikseli otrzymujesz obraz RAW o rozdzielczości 50-80 megapikseli. Jest tylko jeden obraz bez możliwości dostępu do poszczególnych obrazów sekwencji.

Jakie sa zalety korzystania z Sensor-Shift?

Korzystanie z technologii przesunięcia czujnika ma kilka zalet. Robiąc wiele zdjęć, znając informacje o kolorze dla każdej lokalizacji fotokopii i zwiększając rozdzielczość, osiągasz trzy główne rzeczy. Zmniejszasz szum, zmniejszasz morę i zwiększasz ogólną rozdzielczość obrazów.

Szum i poprawiona rozdzielczość

Robiąc wiele zdjęć z subtelną zmianą położenia czujnika, zwiększa się rozdzielczość obrazu, ale także informacje o kolorze na obrazach. Dzięki temu podobne obrazy pozwalają na większe zagłębienie się w obraz z gładszymi kolorami, mniejszym szumem i lepszymi szczegółami.

Obraz o normalnej rozdzielczości.

Obraz w wysokiej rozdzielczości.

Przycięty mocno do obrazu o normalnej rozdzielczości, zaczynasz widzieć szumy, takie jak ziarno i zmienność kolorów.

Oto ten sam kadr w wersji o wysokiej rozdzielczości, kolory i szczegóły są lepsze przy mniejszym szumie.

Mniej mory

Mora to pojawienie się szumu lub wzorów artefaktów, które pojawiają się na obrazach o ciasnych regularnych wzorach. Nowsze czujniki mają zwykle mniej problemów z efektem Moire niż w przeszłości, ale nadal będą pojawiać się na niektórych obrazach.

Przyczyna mory jest zwykle związana z rejestrowaniem ciasnych wzorów, a aparat ma problemy z rozwiązywaniem wzoru, ponieważ ma problemy z wzorami fotomiejsca czujnika. Informacje o kolorach dla fotosites czerwonego, zielonego i niebieskiego mają problemy z krawędziami w tych ciasnych wzorach, ponieważ nie wszystkie kolory dla pojedynczej lokalizacji są rejestrowane.

Dzięki przesunięciu czujnika cały kolor dla każdej lokalizacji jest obecny, więc mora ma tendencję do zanikania.

Obraz w normalnej rozdzielczości.

Obraz w wysokiej rozdzielczości z zaznaczonym obszarem przycięcia

Przycięty obszar na obrazie o standardowej rozdzielczości – zaczyna pojawiać się szum (zadrapania na papierze były już wcześniej).

Obraz o wyższej rozdzielczości ma mniej szumów i więcej szczegółów.

Dlaczego nie używać tego dla każdego obrazu?

Cóż, głównym powodem jest to, że musisz zrobić wiele zdjęć jednej sceny. Oznacza to, że to naprawdę nie działa dobrze w przypadku poruszających się obiektów. Proces ten wymaga co najmniej czterokrotnego czasu naświetlania pojedynczego zdjęcia. Przekłada się to na cztery możliwości poruszania się części kompozycji i/lub aparatu podczas przechwytywania obrazu, pogarszając jakość obrazu.

Takie ograniczenia ograniczają zastosowanie technologii do martwej natury i (statycznej) fotografii krajobrazowej. Każdy ruch w uchwyconej scenie spowoduje powstanie rozmytego lub rozpikselowanego obszaru. Jest to problem w przypadku fotografii krajobrazowej, jeśli wiatr porusza rośliny lub chmury, a także obszary, w których obecna jest bieżąca woda.

Oznacza to również, że zwykle musisz być bardzo stabilny i używać statywu, chociaż producenci mają wyraźne zamiary udostępnienia wersji, które pozwolą na fotografowanie aparatem z ręki (Pentax ma tę funkcję).

Obraz w wysokiej rozdzielczości nagrany na statywie.

Artefakty ruchu są widoczne przy bliższym oglądaniu.

Dziwactwa niektórych systemów

Ponieważ technologia przesunięcia czujnika została wdrożona na różne sposoby i w zależności od używanego systemu, problemy są nieco inne. Głównym dziwactwem jest to, że zazwyczaj potrzebujesz statywu, więc nie ma biegu i broni.

System Sony ma inne ograniczenia polegające na tym, że nie można zobaczyć obrazu, dopóki nie przetworzysz czterech oddzielnych obrazów razem. Oznacza to, że nie możesz przeglądać rozwiązanego obrazu w aparacie. Ponadto, ze względu na dużą liczbę pikseli w A7R mark III, każdy subtelny ruch statywu jest szczególnie zauważalny na wynikowym obrazie. Aby edytować obrazy, musisz również użyć zastrzeżonego oprogramowania Sony, aby scalić obrazy.

Pentax ma kilka ciekawych funkcji. Korzystanie z aplikacji dołączonej do aparatu umożliwia adresowanie ruchu za pomocą algorytmu w oprogramowaniu do usuwania artefaktów ruchu. Działa to lepiej niż oprogramowanie powszechnie używane do manipulacji obrazami, takie jak Adobe.

System Olympus istnieje już od jakiegoś czasu i w najnowszej iteracji Olympus OMD EM1 Mark II każdy wykryty ruch będzie miał zmienione piksele zastąpione częściami jednego z pojedynczych obrazów o normalnej rozdzielczości w obszarach ruchu. Powoduje to nierówną rozdzielczość, ale sprawia, że obraz wygląda lepiej w przypadku wiatru. To również ogranicza, szczególnie jeśli jest dużo ruchu. Często obrazy wyglądają na trochę rozpikselowane.

Obraz drzewa w standardowej rozdzielczości – wszystko jest ostre.

Obraz tego samego drzewa w wysokiej rozdzielczości, ale było wietrznie… Przycięty obszar jest pokazany w żółtym polu.

Powiększony obszar przycięty – ruch wiatru powodował pewne artefakty na obrazie.

Ograniczenia

Największym wyzwaniem stojącym przed rejestracją obrazu z przesunięciem matrycy są poruszające się obiekty. Ponadto próba sparowania lampy błyskowej z aparatem za pomocą przechwytywania obrazu z przesunięciem pikseli może być skomplikowana ze względu na szybkość przechwytywania obrazu, ograniczenia dotyczące recyklingu lampy błyskowej i ogólne problemy z kompatybilnością. Producenci są świadomi tych problemów i pracują nad ich rozwiązaniem.

Ogólnie rzecz biorąc, technologia będzie tylko lepsza

Coraz więcej systemów używa algorytmów do tworzenia obrazów o wyższej rozdzielczości. W miarę dojrzewania technologii implementacje będą uzyskiwać coraz lepsze wyniki, potencjalnie zdolne do radzenia sobie z warunkami ruchu i urządzeń przenośnych.

Zaletą dla producentów jest to, że obrazy o lepszej jakości są wytwarzane bez konieczności stosowania naprawdę drogich czujników o dużej gęstości pikseli (tańsze). Zaletą dla użytkownika jest to, że obrazy mogą mieć lepsze informacje o szumie i kolorze, co zapewnia lepsze wyniki końcowe.

Miłego polowania na idealny obraz w wysokiej rozdzielczości!